2016年在数据中心中下一个大事件是什么?应用程序会告诉你将会是更好的数据保护以及在Scale-out架构下对更多资源的需求。

一月份是做预测和制定短期目标的最好时刻。 现在也是对于鲨鱼出没的高技术水域中的智能分析来说是很好的一年。新年伊始是创新公司从阴影里走出来的良成吉日。但是到底什么才是闪亮和新颖的,哪些是真正影响数据中心的呢?

通过scale-out架构中专注于应用的资源管理系统,我们可以看到有一些新兴的趋势将肯定会对数据中心造成影响。

被唤醒的数据保护

这是一次数据保护软件的回归(或者期待已久的第七章),它能减少或消除大多数企业持续的风险。在PB级别的数据海洋里,数据库的增长和24x7的运作已经让全盘备份到磁盘的程序成为不可能。备份的时间在减少甚至消失,这主要归咎于应用方面不能有太多或任何停机。数据变得非常大,以至于不能备份到一个大型镜像中,也不能通过传统备份方式进行恢复。那么开始尝试从Hadoop集群进行备份恢复吧。在2016年,可以寻找新的数据保护方法,例如Talena提供的直接大数据存储、直接阵列功能,例如HPE 3PAR的 ”flat backup”,它能引导快照到StoreOnce中去;还有Oracle的Zero Data Loss Recovery Appliance,它能让保护那些大型,24x7的Oracle数据库变得非常简单。

Scale-out收敛

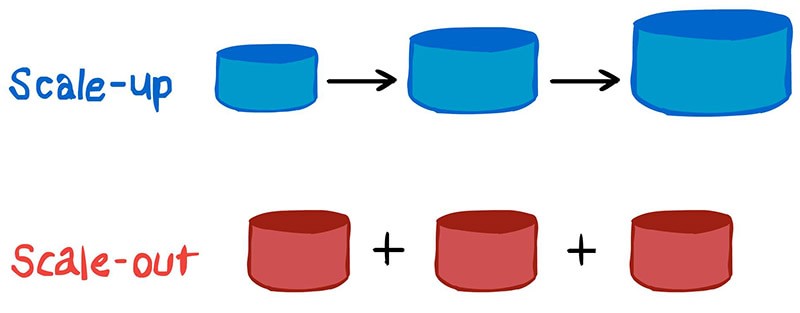

Scale-up整体架构是过时的(2005年才会干的事情)。现在我们在服务器(云/虚拟化/大数据),进程(基于容器的微服务),存储(十亿级别文件对象存储)和内存单元都有分布式、横向扩张、并行网络的设计。现在的问题是我们的很多应用程序并不能好好利用scale-out架构带来的资源优势。我们趋向于喜欢简单的、中心化的资源。好消息是在不同层级,从固有的传统应用映射到更新的IT架构的支持(和方法)越来越多。举个例子,并行文件系统Lustre和GPFS已经成熟,可以成为企业数据中心存储的选择(例如IBM Spectrum Scale)。容器有越来越多的能力部署大型、稳定的应用,包括数据库以及软件定义资源例如软件定义存储。新的对象存储有能力处理十亿级别的对象(例如Qumulo),这会模糊tier-2 架构水平和现在tier-1 对象存储水平的界限。

向scale-out架构的变化对于现有硬件条件来说并不是必要的,不过还是需要你从程序栈的各个方面来考虑这个问题。对大型机来说,现在的大型机在技术上可以说是惊人的大型超融合容器主机——在巨大的铁皮后面运行着大量细小的负载。在新的世界里,要考虑一下哪些层级已经作为聚合池做了最好的优化;哪些是集中整合的资源;哪些是真正的分布式“物联网”类型的节点或者混合云混搭式应用。只有这样才可能让大型机这个黑盒完全交付给应用,并且允许IT优化应用的动态部署。

应用起飞

不管你相不相信DevOps,自动化IT基础架构或者透明的云供应商智能化,应用都需要指定自身需要的资源和QoS (Quality of Service)——而且这个过程现在更加动态化了。基础架构对于针对每一个应用的QoS的动态变化回应处理得越来越聪明。VMware提供了一些很好的动态灵活的基础架构的例子,这些例子也包含了软件定义的资源,例如NSX网络和Virtual SAN存储,这些都可以应用针对每个VM的QoS策略。

容器也同样许诺可以定义应用程序动态需求的每一个组件的资源。当然,这里还缺少了让应用保证自己的服务等级的针对变化的智能化。可以注意一下基于大数据的管理系统,这些系统集成了基础架构和应用性能管理视图,将有助于对业务进行指导。

延长数据价值的生命线

数据的价值随着使用时间而变得越来越少,不过通过使用活动存档和大数据,大部分数据在过了自身活动运营使用的时间之后还有很长时间的价值。在数据大海中,内嵌的分析和划算的scale-out存储正在改变数据价值曲线的根本。今年也是你需要看一看隐藏在你的数据背后的价值的时候了。不要忘记考虑新的内部的(比如物联网)和外部的(合作方,供应商,第三方)数据资源的组合。

以上三种趋势都值得更深层的考察和开放的思维。尽管只是保持我们已经知道的很容易,但是我们最好保持开放的思想。一些人可能会问我们的基础架构到底需要多智能呢?但是真正的问题应该是基础架构它可以智能到什么程度吧。

原文来自TechTarget

文章评论

看一看来瞧一瞧,这个博客真是好!

数据安全确实非常重要!